Yoshua Bengio dice que la competencia en el campo podría significar peligro, ya que el panel internacional señala el potencial malicioso de la IA

Dan Milmo editor de tecnología globalMiércoles 29 de enero de 2025 08:00 ESTcompartir

El potencial de que los sistemas de inteligencia artificial se utilicen para actos maliciosos está aumentando, según un informe histórico de expertos en IA, con el autor principal del estudio advirtiendo que DeepSeek y otros disruptores podrían aumentar el riesgo de seguridad.

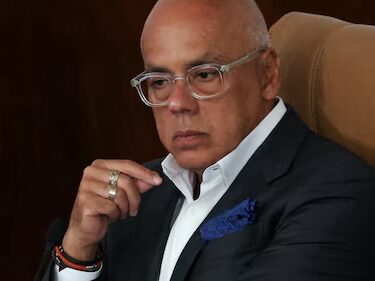

Yoshua Bengio, considerado como uno de los padrinos de la IA moderna, dijo que los avances de la startup china DeepSeek podrían ser un desarrollo preocupante en un campo que ha sido dominado por los Estados Unidos en los últimos años.

“Va a significar una carrera más reñida, lo que generalmente no es algo bueno desde el punto de vista de la seguridad de la IA”, dijo.

Bengio dijo que las empresas estadounidenses y otros rivales de DeepSeek podrían centrarse en recuperar su liderazgo en lugar de en la seguridad. OpenAI, el desarrollador de ChatGPT, que DeepSeek ha desafiado con el lanzamiento de su propio asistente virtual, se comprometió esta semana a acelerar los lanzamientos de productos como resultado.

“Si imaginas una competencia entre dos entidades y una piensa que están muy por delante, entonces pueden permitirse ser más prudentes y aún así saber que se mantendrán por delante”, dijo Bengio. “Mientras que si tienes una competencia entre dos entidades y piensan que la otra está al mismo nivel, entonces necesitan acelerar. Entonces tal vez no le den tanta atención a la seguridad”.

Bengio estaba hablando a título personal antes de la publicación de un amplio informe sobre la seguridad de la IA.

El primer informe completo de Seguridad Internacional de la IA ha sido compilado por un grupo de 96 expertos, incluido el ganador del premio Nobel Geoffrey Hinton. Bengio, coganador en 2018 del premio Turing, conocido como el premio Nobel de informática, fue comisionado por el gobierno del Reino Unido para presidir el informe, que se anunció en la cumbre mundial de seguridad de la IA en Bletchley Park en 2023. Los miembros del panel fueron nominados por 30 países, así como por la UE y la ONU. La próxima cumbre global de IA se llevará a cabo en París los días 10 y 11 de febrero.

El informe establece que desde la publicación de un estudio interino en mayo del año pasado, los sistemas de IA de uso general, como los chatbots, se han vuelto más capaces en “dominios que son relevantes para el uso malicioso”, como el uso de herramientas automatizadas para resaltar vulnerabilidades en el software y los sistemas de TI, y dar orientación sobre la producción de armas biológicas y químicas.

Dice que los nuevos modelos de IA pueden generar instrucciones técnicas paso a paso para crear patógenos y toxinas que superen la capacidad de los expertos con doctorados, y OpenAI reconoce que su modelo avanzado o1 podría ayudar a los especialistas a planificar cómo producir amenazas biológicas.

Sin embargo, el informe dice que es incierto si los principiantes podrían actuar sobre la orientación, y que los modelos también se pueden usar con fines beneficiosos, como en medicina.

Hablando con The Guardian, Bengio dijo que ya habían surgido modelos que podrían, con el uso de una cámara de teléfono inteligente, teóricamente guiar a las personas a través de tareas peligrosas como tratar de construir un arma biológica.

“Estas herramientas son cada vez más fáciles de usar por parte de los no expertos, porque pueden descomponer una tarea complicada en pasos más pequeños que todos pueden entender, y luego pueden ayudarte de forma interactiva a hacerlo bien. Y eso es muy diferente a usar, por ejemplo, la búsqueda de Google”, dijo.

El informe dice que los sistemas de IA han mejorado significativamente desde el año pasado en su capacidad para detectar fallas en el software de forma autónoma, sin intervención humana. Esto podría ayudar a los hackers a planificar ciberataques.

Sin embargo, el informe dice que llevar a cabo ataques del mundo real de forma autónoma está más allá de los sistemas de IA hasta ahora porque requieren “un nivel excepcional de precisión”.

En otra parte de su análisis de los riesgos que plantea la IA, el informe señala un aumento significativo en el contenido deepfake, donde la tecnología se utiliza para producir una semezcidad convincente de una persona, ya sea su imagen, voz o ambas. Dice que los deepfakes se han utilizado para engañar a las empresas para que entreguen dinero, para chantajear y para crear imágenes pornográficas de personas. Dice que medir el nivel preciso de aumento en tal comportamiento es difícil debido a la falta de estadísticas completas y confiables.

También hay riesgos de uso malicioso porque los llamados modelos de código cerrado, donde el código subyacente no se puede modificar, pueden ser vulnerables a los jailbreaks que eluden las barandillas de seguridad, mientras que los modelos de código abierto como Llama de Meta, que se pueden descargar gratis y pueden ser ajustados por especialistas, plantean riesgos de “facilitar el uso malicioso o equivocado” por parte de malos actores.

En una adición de última hora al informe escrito por Bengio, el científico informático canadiense señala la aparición en diciembre, poco después de que se finalizara el informe, de un nuevo modelo avanzado de “razonamiento” de OpenAI llamado o3. Bengio dijo que su capacidad para hacer un gran avance en una prueba clave de razonamiento abstracto era un logro que muchos expertos, incluido él mismo, habían pensado hasta hace poco que estaba fuera de su alcance.saltar la promoción pasada del boletín

“Las tendencias evidenciadas por o3 podrían tener profundas implicaciones para los riesgos de IA”, escribe Bengio, quien también señaló el modelo R1 de DeepSeek. “Las evaluaciones de riesgos en este informe deben leerse con el entendimiento de que la IA ha ganado capacidades desde que se escribió el informe”.

Bengio le dijo a The Guardian que los avances en el razonamiento podrían tener consecuencias para el mercado laboral al crear agentes autónomos capaces de llevar a cabo tareas humanas, pero también podrían ayudar a los terroristas.

“Si eres un terrorista, te gustaría tener una IA que sea muy autónoma”, dijo. “A medida que aumentamos la agencia, aumentamos los beneficios potenciales de la IA y aumentamos los riesgos”.

Sin embargo, Bengio dijo que los sistemas de IA aún no habían podido lograr la planificación a largo plazo que podría crear herramientas totalmente autónomas que evadan el control humano. “Si una IA no puede planificar a largo plazo, difícilmente podrá escapar de nuestro control”, dijo.

En otro lugar, el informe de casi 300 páginas cita preocupaciones “bien establecidas” sobre la IA, incluida la generación de estafas e imágenes de abuso sexual infantil; resultados sesgados y violaciones de privacidad, como la filtración de información confidencial compartida con un chatbot. Dijo que los investigadores no habían sido capaces de “resolver completamente” esos temores.

La IA se puede definir libremente como sistemas informáticos que realizan tareas que normalmente requieren inteligencia humana.

El informe, cuyo título completo es el Informe Científico Internacional sobre la Seguridad de la IA Avanzada, señala el impacto “rápido crecimiento” de la IA en el medio ambiente a través del uso de centros de datos y el potencial de que los agentes de IA tengan un impacto “profundo” en el mercado laboral.

Dice que el futuro de la IA es incierto, con una amplia gama de resultados posibles en un futuro próximo, incluidos “resultados muy positivos y muy negativos”. Dice que las sociedades y los gobiernos todavía tienen la oportunidad de decidir qué camino toma la tecnología.

“Esta incertidumbre puede evocar fatalismo y hacer que la IA aparezca como algo que nos sucede. Pero serán las decisiones de las sociedades y los gobiernos sobre cómo navegar por esta incertidumbre las que determinen qué camino tomaremos”, dice el informe