¿Cómo cambiarán las herramientas de chat de inteligencia artificial el futuro de la escritura?

Las herramientas de chat con inteligencia artificial pueden cambiar nuestra forma de escribir, haciéndola más eficaz y precisa. Por ejemplo, pueden ayudar a revisar la ortografía y la gramática, sugerir sinónimos e incluso generar textos completos. Esta tecnología también podría hacer la escritura más accesible a las personas que tienen dificultades con el lenguaje, como las que están aprendiendo un nuevo idioma o las que padecen ciertas discapacidades.

Sin embargo, es importante señalar que el uso de la IA en la escritura también plantea problemas éticos sobre la autenticidad y originalidad del trabajo que se produce.

Los dos párrafos anteriores han sido escritos con la herramienta de chat ChatGPT. La herramienta fue desarrollada por la empresa de software OpenAI, los mismos que crearon DALL-E, una de las herramientas de IA que se hicieron virales el año pasado por su capacidad de convertir texto en imágenes. Imágenes aterradoras.

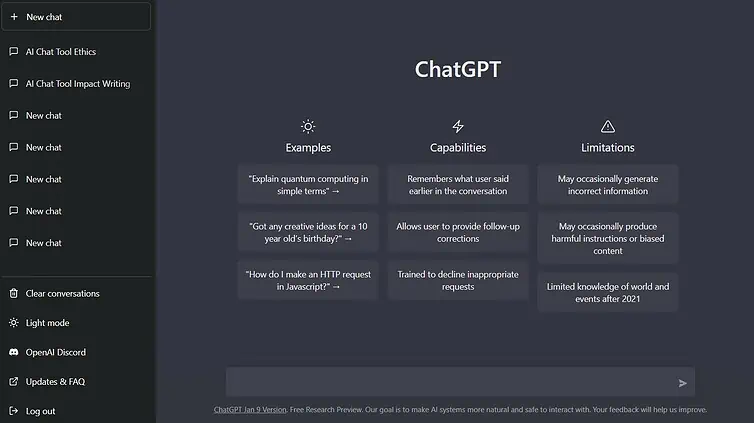

ChatGPT se puso a disposición del público el 30 de noviembre. Al abrir ChatGPT , la página web señalaba que la herramienta sería capaz de interactuar con los usuarios «de forma conversacional». Entre los talentos de ChatGPT están que: «…puede responder a preguntas de seguimiento, admitir errores, cuestionar premisas incorrectas y rechazar peticiones inapropiadas».

¿Cómo funciona?

Tomando grandes cantidades de datos, la herramienta recopila la información basándose en las indicaciones del usuario.

Suena fácil, pero es muy fácil que la IA simplemente suelte tonterías sin el «entrenamiento» adecuado. ChatGPT ha sido noticia y ha causado revuelo en Internet precisamente porque en realidad suena bastante humano. ¿Quizá demasiado humano?

A modo de comparación, existen otras herramientas de IA que permiten jugar con algunos de sus parámetros, lo que da una idea de lo que ocurre entre bastidores.

Un ejemplo es Inferkit, creado por el canadiense Adam King. Inferkit permite «subir» la «temperatura de muestreo», aumentando la aleatoriedad del texto. El resultado suele ser desternillante.

ChatGPT se basa en lo que se conoce como arquitectura Generative Pre-trained Transformer (GPT). Esto significa esencialmente que el software utiliza algoritmos de aprendizaje profundo para analizar y generar texto. El modelo utiliza enormes volúmenes de datos de Internet para «entender» los matices del lenguaje natural, tal y como lo producen los humanos.

Analiza el texto de entrada dividiéndolo en componentes más pequeños, como palabras o frases cortas. Juntándolo todo, ChatGPT revela su respuesta.

Lo que distingue a ChatGPT es que se entrenó mediante el Aprendizaje por Refuerzo a partir de la Retroalimentación Humana (RLHF).

Los instructores humanos de IA afinaron el modelo inicial de ChatGPT «jugando a dos bandas» en la interacción y dando a la IA información sobre cuál de sus respuestas era la más adecuada. Un modelo de «recompensa» entrena a la IA para que reconozca cuándo ha dado respuestas que suenan humanas.

Los desarrolladores señalan algunos inconvenientes del modelo, como las respuestas ocasionales sin sentido, la alta sensibilidad a los cambios en la frase de entrada, la repetición, las suposiciones que se hacen cuando las instrucciones no son claras y la susceptibilidad a responder a peticiones inapropiadas, incluidas las que contienen instrucciones perjudiciales o las que conducen a un comportamiento sesgado de la IA.

Y el potencial de uso indebido es una de las preocupaciones públicas más serias sobre ChatGPT y otros programas de IA de procesamiento lingüístico.

En la escritura académica, por ejemplo, ChatGPT o alguna herramienta equivalente podría ser utilizada por un estudiante para producir un ensayo. El estudiante no ha hecho el trabajo y, en esencia, ha plagiado. Pero sería muy difícil demostrarlo, ya que ChatGPT está diseñado específicamente para parecer humano.

Edward Tian, estudiante de 22 años de la Universidad de Princeton, ha desarrollado una aplicación que, según afirma, puede determinar «rápida y eficazmente» si ChatGPT es el autor de la redacción de un estudiante.

OpenAI se asoció con el Centro de Seguridad y Tecnologías Emergentes de la Universidad de Georgetown y el Observatorio de Internet de Stanford para elaborar un informe centrado en los posibles usos indebidos del software de lenguaje de IA, así como en posibles métodos de mitigación.

Mucho más preocupante que una tarea universitaria plagiada es el posible uso de herramientas de lenguaje de IA para difundir información errónea.

En una declaración publicada en el sitio web de OpenAI, se afirma: «Creemos que es fundamental analizar la amenaza de las operaciones de influencia posibilitadas por la IA y esbozar las medidas que pueden tomarse antes de que los modelos lingüísticos se utilicen para operaciones de influencia a gran escala. Esperamos que nuestra investigación informe a los responsables políticos que se inician en los campos de la IA o la desinformación, y estimule la investigación en profundidad de posibles estrategias de mitigación para desarrolladores de IA, responsables políticos e investigadores de la desinformación».

Por ahora, parece que la inteligencia artificial ha llegado para quedarse, nos guste o no.

Desde luego, tiene sus usos. Como decía mi erudito amigo ChatGPT al principio de este artículo, tiene el potencial de ayudar a escribir y hacer el lenguaje más accesible. Pero parece que la legislación tendrá que ponerse al día con el rápido desarrollo de la tecnología para evitar abusos.

Mientras tanto, puede estar seguro de que he escrito este artículo yo solo. ¿O no?

ENLACE ORIGINAL: What does AI tool ChatGPT mean for the future of writing? (cosmosmagazine.com)